डीपफेक टेक्नोलॉजी: एक खतरनाक सामाजिक चुनौती

Table of Contents

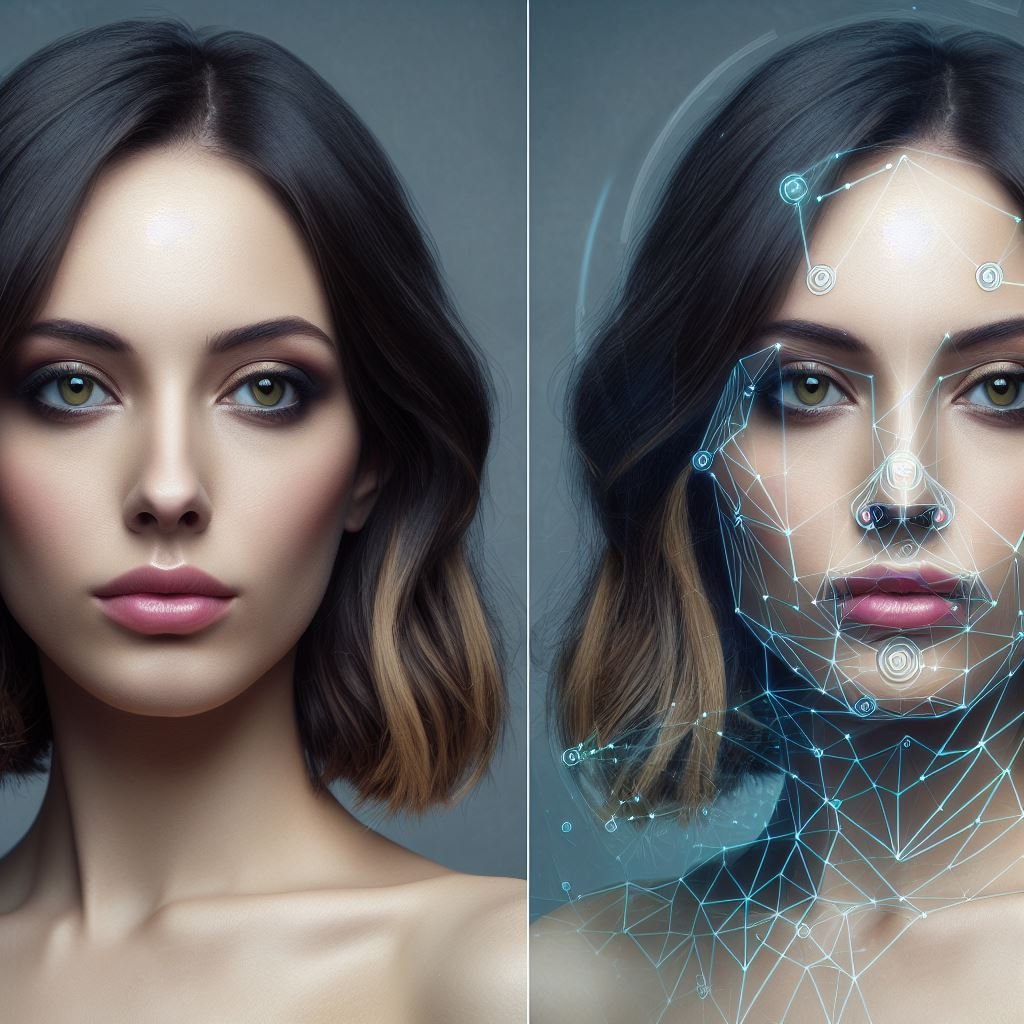

दोस्तों आइये हम इस पोस्ट में जानते हैं की कैसे डीपफ़ेक टेक्नोलॉजी समाज के लिए ख़तरनाक़ हो सकती है डीपफेक टेक्नोलॉजी आजकल हमारे समाज में एक नई प्रकार की तकनीक का प्रतीक है, जिसके द्वारा किसी व्यक्ति का चेहरा दूसरे के चेहरे में मिला सकता है। यह तकनीक रुझान में है, लेकिन इसके समाज पर कई प्रकार के प्रभाव हो सकते हैं। इस लेख में, हम जानेंगे कि डीपफेक टेक्नोलॉजी समाज के लिए कैसे खतरनाक हो सकती है और इसके साथ ही इसके विभिन्न पहलुओं को भी समझेंगे।

डीपफेक टेक्नोलॉजी: क्या है?

पहले हम इस तकनीक को समझते हैं। डीपफेक टेक्नोलॉजी एक ऐसी तकनीक है जिसमें किसी की तस्वीर या वीडियो को डिजिटल रूप में मॉडिफाई किया जा सकता है ताकि वह व्यक्ति दूसरे के रूप में दिखे। यह तकनीक गहरे लर्निंग और आर्टिफिशियल इंटेलिजेंस के साथ जुड़ी होती है और यह बेहद विस्तार में उपयोग की जाती है।डीपफ़ेक ने ‘ह्यूमन इमेज सिंथेसिस’ की खोज की है।

डीपफेक तकनीक चलते-फिरते और बोलते लोगों की पूरी तरह से नकल कर सकती है, जैसे हम फोटो को नकल करते हैं। मतलब, हम स्क्रीन पर किसी भी जीव को चलते-फिरते, बोलते या बोलते देख सकते हैं, चाहे वह नकली हो या नकली हो। इस टेक्नोलॉजी के आधार पर बनाए गए ऐप बहुत घातक हो सकते हैं। इससे एक व्यक्ति का चेहरा दूसरे व्यक्ति के चेहरे पर लगाया जा सकता है, इतनी सफाई और बारीकी से कि स्रोत चेहरे के हर हाव-भाव फ़र्ज़ी चेहरे पर दिखते हैं

डीपफेक टेक्नोलॉजी का खतरा

इस तकनीक का उपयोग बेहद जानलेवा हो सकता है और समाज के लिए खतरनाक हो सकता है। निम्नलिखित कुछ तरीकों से डीपफेक टेक्नोलॉजी का सामाजिक और मानसिक प्रभाव हो सकता है:

1.धोखाधड़ी:

डीपफेक टेक्नोलॉजी का उपयोग धोखाधड़ी के उद्देश्य से किया जा सकता है, जिससे व्यक्तिगत और सामाजिक जीवन में बड़ी हानि हो सकती है।

2.स्थायिता के मानसिक प्रभाव:

डीपफेक वीडियो या फ़ोटो देखकर लोग अपने शरीर और चेहरे के प्रति असमंजस महसूस कर सकते हैं, जो स्थायिता के मानसिक प्रभाव पैदा कर सकता है।

3.गुमराही:

डीपफेक वीडियो या छवियों के कारण गुमराही हो सकती है, जिससे समाज में आपसी भ्रांतियाँ पैदा हो सकती हैं।

सुरक्षा और गोपनीयता

डीपफेक टेक्नोलॉजी से संबंधित एक और महत्वपूर्ण मुद्दा सुरक्षा और गोपनीयता है। जब यह तकनीक दुरुपयोग होता है,डीपफ़ेक (Deepfake, “deep learning” + “fake” ) का अर्थ है कृत्रिम मीडिया , जिसमें एक व्यक्ति को एक मौजूदा छवि या वीडियो में इतना समान बनाया जाता है कि उनमें अंतर करना मुश्किल होता है।

भ्रष्ट मीडिया बनाना बहुत पुराना नहीं है, लेकिन डीपफेक ने मशीन लर्निंग और AI जैसी शक्तिशाली तकनीकों का उपयोग करके दृश्य और ऑडियो सामग्री बनाने में बहुत बड़ा कदम उठाया है। डीपफेक बनाने के लिए मुख्य मशीन सीखने के तरीके डीप लर्निंग पर आधारित हैं और प्रशिक्षण संबंधी न्यूरल नेटवर्क आर्किटेक्चर, जैसे ऑटोएन्कोडर्स या जेनरेटर एडवरसियर नेटवर्क (जीएएन), को शामिल करते हैं।

डीपफ़ेक ने ‘ह्यूमन इमेज सिंथेसिस’ तकनीक विकसित की है। ये तकनीक चलते-फिरते और बोलते लोगों की पूरी तरह से नकल कर सकती है, जैसे हम फोटो को नकल करते हैं। मतलब, हम स्क्रीन पर किसी भी जीव को चलते-फिरते, बोलते या बोलते देख सकते हैं, चाहे वह नकली या नकली हो।

इस टेक्नोलॉजी के आधार पर बनाए गए ऐप बहुत घातक हो सकते हैं। इससे एक व्यक्ति का चेहरा दूसरे व्यक्ति के चेहरे पर लगाया जा सकता है, इतनी सफाई और बारीकी से कि स्रोत चेहरे के सभी हाव-भाव फ़र्ज़ी चेहरे पर दिखते हैं।

डीपफ़ेक टेक्नोलॉजी को निम्नलिखित श्रेणियों में रखा जा सकता है:

- चेहराजिसमें वीडियो में किसी अन्य व्यक्ति का चेहरा स्वचालित रूप से बदल जाता है।

- लिपस्टिक: जिसमें स्रोत वीडियो को संशोधित किया जाता है, ताकि बोलने वाले व्यक्ति के होंठ और मुंह मनमानी ऑडियो रिकॉर्डिंग के अनुरूप हों।

- कठपुतली गुरु: जिसमें एक कलाकार एक लक्षित व्यक्ति को एक कैमरे के सामने बैठाकर मिमिक (सिर और आंखो का चलना, चेहरे के हाव भाव) करता है।

डीपफ़ेक किस हद तक खतरनाक है?

दो साल पुरानी इस टेक्नोलॉजी का शिकार काफी प्रसिद्ध अभिनेत्री हो चुकी है। इन नामों की संख्या बहुत अधिक है। गेम ऑफ थ्रोंस में मार्जरी का किरदार निभाने वाली नेटली डोर्मर, वंडर वुमन में गाल गदोट, हैरी पॉटर में एमा वॉटसन, नेटली पोर्टमन और भारत में ऐश्वर्या, कटरीना, प्रियंका चोपड़ा और हाल ही में साउथ की सुपरस्टार रस्मिका मंदाना सहित कई अन्य अदाकाराओं के इस तरह के फर्जी वीडियो फैलाने की कोशिश की गई है।

बातचीत की शैली और चेहरे के हाव-भाव व्यक्ति के संदर्भ से भिन्न हो सकते हैं।

उदाहरण के लिए, एक वास्तविक साक्षात्कार में तनावपूर्ण प्रश्नों का उत्तर देते समय आपके चेहरे के हाव-भाव बहुत अलग हो सकते हैं। डीपफ़ेक का व्यापक उपयोग लोगों को लगता है कि वे भी फर्जी वीडियो को निकाल सकते हैं। मतलब यह था कि इतनी वास्तविकता वाली वास्तविक वीडियो ही नकली लगने लगी।

अब हम सब मिलकर मानते हैं कि चित्र संपादित हो सकते हैं, या फिर फोटोशॉप, जो अब अक्सर संपादित होते हैं और बाकी चित्रों को संदेह की दृष्टि से देखा जाता है। अब पूरे-पूरे सबरेडिट्स और इंस्टाग्राम अकाउंट हैं, जहां लोग बुरे फोटोशॉप के बारे में पोस्ट करते हैं, विश्लेषण करते हैं और उसका मज़ाक उड़ाते हैं।

वास्तविक फुटेज से डीपफेक को समझना अभी भी आसान है, लेकिन कुछ छलरचित वीडियो इतनी सफाई से संपादित होते हैं कि उनसे अलग करना मुश्किल है। हाल की विश्वव्यापी चुनावों ने राजनीतिक संगठनों और उनके पूर्वाग्रहों को दिखाया है, जो फ़ेक न्यूज़ के साथ लोगों को माइक्रोट्रैगेट करते हैं; इसलिए, राजनीतिक विरोधियों को परास्त करने के लिए डीपफ़ेक का उपयोग करना घातक हो सकता है।

डीपफ़ेक, एक आगामी AI खोज, 30 सेकंड में एक महिला को नग्न कर देता है। जिसमें आप सिर्फ एक महिला की फोटो डालते हैं और ऐप उस महिला की फोटो को इंटरनेट पर खोज करके जोड़ देता है, बिना किसी फोटोशॉप जैसे सॉफ्टवेयर से एडिट किया जा सकता है ।

महिलाओं के खिलाफ अपराध को बढ़ावा न मिले, इस लिए इस डीपन्यूड नामक ऐप को बंद कर दिया गया है. लेकिन वह मानसिकता का क्या है जो आर्टिफीशियल इंटेलिजेंस जैसे टेक्नोलॉजिकल क्रांति का उपयोग कर रही है, जो इतनी खतरनाक स्थिति पैदा कर रही है?

तेजी से विकसित और सुधारित तकनीक ने महिलाओं की सार्वजनिक सुरक्षा में एक महत्वपूर्ण भूमिका निभाने की क्षमता हासिल की है, लेकिन यह भी उन्हें उतनी ही कमजोर बना रही है जितना वे इस युग से पहले थे। जैसा कि डीप-न्यूड ऐप और डीपफ़ेक वीडियो से देखा गया है। परिणामस्वरूप, चित्रों में स्पष्ट रूप से छल है, लेकिन त्वचा धुंधली और बदरंग है जब आप उन्हें करीब से देखते हैं। लेकिन जब आवश्यक हो, वह देखने वाले को आश्वस्त करती हैं।

भ्रष्ट समाचार, जैसा कि हमने पहले देखा है, पकड़ा जा सकता है, लेकिन इसका अर्थ यह नहीं है कि इसे क्लिक नहीं किया जा सकता या ऑनलाइन पढ़ा और साझा नहीं किया जा सकता है। क्योंकि इंटरनेट का उद्देश्य लोगों की दिलचस्पी से पैसा बनाना और बिना किसी बाधा के जानकारी को साझा करना है। इसका अर्थ है कि डीपफ़ेक का उपयोग हमेशा करने वाले लोग होंगे। लेकिन इस टेक्नोलॉजी का प्रभाव किस तरह रोका जा सकता है, यह निश्चित रूप से एक महत्वपूर्ण प्रश्न है। और आखिरकार, कितनी भी अच्छी तकनीक हो, डीपफेक को रोकने के लिए कोई उपाय नहीं मिलता। साथ ही, कानूनी उपाय, चाहे कितने भी प्रभावी हों, आम तौर पर डीपफ़ेक के फैलने के बाद ही लागू हो सकते हैं।

सार्वजनिक जागरूकता में सुधार भी डीपफ़ेक से मुकाबला करने की योजना का एक और हिस्सा हो सकता है। जैसे, चंद दिनों या घंटों के अंदर किसी महत्वपूर्ण व्यक्ति का संदिग्ध डीपफेक वीडियो मिलता है, तो यह पता चलता है कि वीडियो में छेड़छाड़ किस हद तक हुई है। यह सूचना डीपफ़ेक को कम करने में मदद कर सकती है, लेकिन इसे रोक नहीं सकती।